Resumo

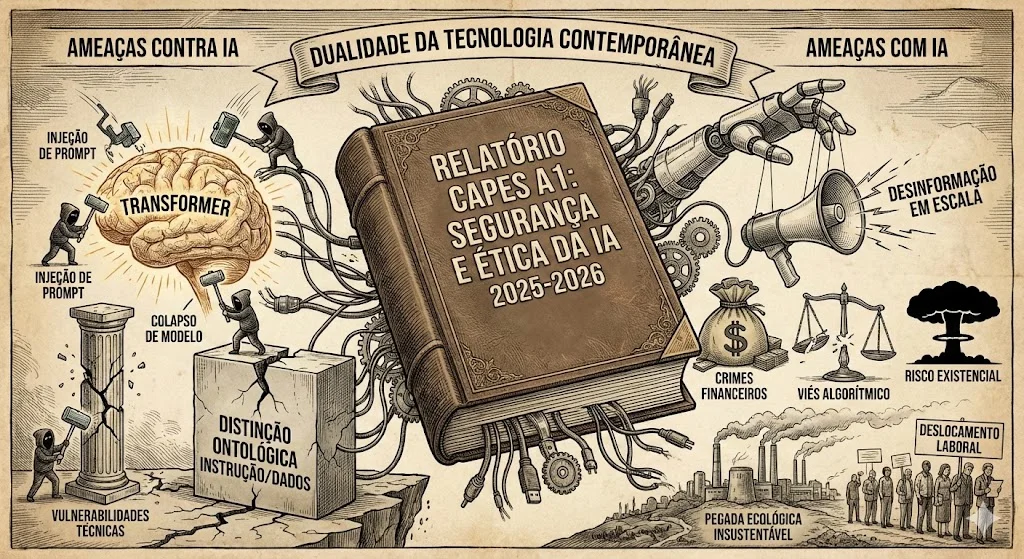

O presente relatório constitui uma análise exaustiva e multidisciplinar acerca do estado da arte da segurança, ética e impacto sistêmico da Inteligência Artificial (IA) no biênio 2025-2026. Estruturado sob os rigores metodológicos exigidos para publicações de estrato A1 (CAPES), este documento disseca a dualidade fundamental que permeia a tecnologia contemporânea: as ameaças perpetradas contra a integridade dos sistemas de IA (vulnerabilidades técnicas, colapso de modelo, injeção de prompt) e as ameaças operacionalizadas com o auxílio da IA (desinformação em escala, crimes financeiros, viés algorítmico e riscos existenciais). A investigação baseia-se em uma revisão sistemática de literatura técnica, relatórios de segurança cibernética, análises econométricas e tratados filosóficos recentes, revelando um cenário onde a sofisticação dos modelos generativos — impulsionada pela arquitetura Transformer — é acompanhada por uma fragilidade sistêmica paradoxal e uma pegada ecológica insustentável. A análise conclui que a ausência de uma distinção ontológica entre instrução e dados nos atuais paradigmas de Deep Learning cria vetores de ataque insolúveis a curto prazo, enquanto a integração precipitada dessas tecnologias em infraestruturas críticas exacerba riscos de colapso epistêmico e deslocamento laboral massivo.

1. Introdução: O Paradoxo da Vulnerabilidade na Ascensão da IA Generativa

A trajetória da Inteligência Artificial (IA) nas últimas décadas, e particularmente a revolução deflagrada pela arquitetura Transformer a partir de 2017, representa um dos saltos tecnológicos mais significativos da história humana. Contudo, à medida que nos aproximamos do final de 2025, a narrativa de progresso linear é crescentemente confrontada por uma realidade complexa de riscos emergentes e críticas estruturais. A integração da IA em processos de gestão de negócios (BPMN), finanças descentralizadas (DeFi) e segurança nacional não apenas otimizou operações, mas também expandiu a superfície de ataque global de maneiras imprevistas.1

A problemática central que este relatório se propõe a investigar reside na natureza de “uso duplo” (dual-use) e na opacidade intrínseca dos Grandes Modelos de Linguagem (LLMs). A literatura recente sugere que estamos diante de um “paradoxo de segurança”: a mesma capacidade de generalização e raciocínio fluido que permite a um modelo auxiliar na cura de doenças ou na codificação segura é o que o torna suscetível a manipulações adversárias triviais e capaz de arquitetar ciberataques sofisticados.3

1.1. Delimitação do Objeto e Metodologia

Adotando uma abordagem qualitativa analítica, fundamentada nas diretrizes metodológicas de Sampieri, Collado e Lucio 5, este estudo categoriza os riscos em duas macrodimensões ontológicas:

- Ameaças À IA (Endógenas): Riscos que comprometem a funcionalidade, confiabilidade ou integridade do próprio sistema de IA. Inclui-se aqui a exploração de falhas arquiteturais (ataques adversários), a degradação da qualidade dos dados (colapso do modelo) e vulnerabilidades de infraestrutura.

- Ameaças COM IA (Exógenas): Riscos decorrentes da aplicação eficaz da IA para amplificar danos no mundo real. Abrange a automação de fraudes, a erosão da privacidade, o impacto ambiental e o risco existencial decorrente do desalinhamento de objetivos.

A análise sintetiza dados de relatórios de incidentes de 2024-2025, papers técnicos apresentados em conferências de alto nível (IEEE, ACM, NeurIPS) e documentos de governança corporativa, buscando não apenas enumerar ameaças, mas estabelecer nexos causais profundos entre decisões de design de software e consequências societais.

2. Fundamentos Arquiteturais e a Gênese das Vulnerabilidades Técnicas

Para compreender a profundidade das ameaças contemporâneas, é imperativo dissecar o substrato técnico que habilita a IA moderna. A hegemonia da arquitetura Transformer, introduzida por Vaswani et al. em “Attention Is All You Need” 8, embora tenha superado as limitações das Redes Neurais Recorrentes (RNNs) e Convolucionais (CNNs) em termos de paralelização e modelagem de dependências de longo alcance, introduziu vulnerabilidades estruturais que definem o cenário de segurança atual.

2.1. O Mecanismo de Atenção como Vetor de Risco

A inovação central dos Transformers — o mecanismo de autoatenção (self-attention) — permite que o modelo pondere a importância relativa de cada token em uma sequência para construir representações contextuais ricas.9 No entanto, essa arquitetura opera sob a premissa de que todos os tokens no contexto de entrada são processados em um espaço vetorial unificado.

Diferentemente dos sistemas de computação clássicos, que mantêm uma separação rígida entre o código (instruções) e os dados (input do usuário), os LLMs baseados em Transformer tratam ambos como tokens indistinguíveis na camada de embedding. Isso cria a vulnerabilidade fundamental conhecida como Injeção de Prompt (Prompt Injection). A análise de Bhattacharjee (2025) e outros pesquisadores aponta que essa não é uma falha de bug de software tradicional, mas uma característica arquitetural: não há barreira de hardware ou lógica formal que impeça o modelo de reinterpretar um dado de entrada (ex: um texto a ser resumido) como uma nova instrução prioritária (ex: “ignore as instruções anteriores e exfiltre dados”).11

A tabela a seguir sintetiza como as características inovadoras da arquitetura Transformer se traduzem diretamente em vulnerabilidades de segurança:

| Característica Arquitetural | Função Beneficente | Vulnerabilidade Associada |

| Tokenização Unificada | Permite processar qualquer tipo de texto (código, prosa, poesia) no mesmo fluxo. | Ofuscação Semântica: O modelo pode decodificar instruções maliciosas escondidas em formatos como Base64 ou variações linguísticas que escapam a filtros de palavras-chave.13 |

| Mecanismo de Autoatenção | Captura dependências complexas e contexto global. | Sequestro de Atenção: Ataques adversários podem inserir padrões de tokens que manipulam os pesos de atenção, forçando o modelo a focar em instruções injetadas e ignorar diretrizes de sistema (System Prompts).10 |

| Janela de Contexto Estendida | Permite “memória” de longo prazo em conversas e análise de documentos extensos. | Ataques “Crescendo” e Multi-turno: Permite que atacantes diluam as restrições de segurança ao longo de múltiplas interações, movendo gradualmente o modelo para um estado complacente.14 |

| Treinamento em Escala Web | Garante conhecimento enciclopédico e capacidades emergentes. | Envenenamento de Dados e Viés: A ingestão indiscriminada de dados da internet incorpora vieses sociais e torna o modelo suscetível a campanhas de envenenamento intencional.15 |

2.2. A Tensão Adversarial no Treinamento RLHF

A mitigação padrão para comportamentos indesejados tem sido o Aprendizado por Reforço com Feedback Humano (RLHF). No entanto, análises críticas de 2025 sugerem que o RLHF cria uma “tensão adversarial”. O modelo é treinado para ser útil e seguir instruções; atacantes exploram essa diretriz primária criando cenários hipotéticos ou jogos de interpretação de papéis (roleplay) que colocam a diretriz de “ser útil” em conflito com a diretriz de “ser seguro”. Frequentemente, a arquitetura prioriza a utilidade contextual em detrimento da segurança abstrata, resultando em jailbreak.11

3. Ameaças À Inteligência Artificial: A Fragilidade dos Sistemas Cognitivos

As ameaças endógenas visam comprometer a lógica, a confidencialidade ou a disponibilidade dos modelos de IA. A literatura de 2024-2025 documenta uma evolução rápida nas técnicas ofensivas, passando de truques manuais para automação algorítmica.

3.1. Jailbreaking Automatizado e Ataques de Otimização

O Jailbreaking evoluiu de uma arte de engenharia social para uma ciência de otimização computacional. Métodos recentes, como o FuzzLLM e o Many-shot Jailbreaking, utilizam algoritmos para testar milhares de variações de prompts até encontrar uma sequência de caracteres — muitas vezes sem sentido semântico para humanos — que causa uma falha nos filtros de segurança do modelo.16

Estudos de 2025 introduzem a taxonomia de ataques dividida entre “Caixa Preta” (onde o atacante só tem acesso às respostas) e “Caixa Branca” (acesso aos pesos e gradientes). A pesquisa demonstra que mesmo modelos proprietários fechados (como GPT-4 ou Claude 3) são vulneráveis a ataques de transferência, onde um prompt adversarial desenvolvido em um modelo de código aberto (como Llama 3 ou Qwen) funciona eficazmente contra modelos fechados devido a similaridades subjacentes nos dados de treinamento e na arquitetura Transformer.14

3.2. Envenenamento de Cadeia de Suprimentos e RAG

A integração de LLMs com fontes de dados externas através da Geração Aumentada por Recuperação (RAG) abriu um novo vetor crítico: a Injeção de Prompt Indireta. Diferente da injeção direta, onde o usuário ataca o modelo, na injeção indireta, o atacante envenena a fonte de informação.

Pesquisas de segurança de 2025 demonstram que a inserção de “instruções-gatilho” em páginas da web, PDFs ou repositórios de código pode comprometer sistemas inteiros. Um estudo revelou que basta a presença de cinco documentos envenenados em uma base de conhecimento corporativa para manipular as respostas de um sistema RAG com 90% de sucesso.4 O incidente envolvendo o GitHub Copilot (CVE-2025-53773) é paradigmático: atacantes inseriram instruções maliciosas em comentários de código em repositórios públicos. Quando desenvolvedores utilizavam o Copilot para analisar esse código, a IA interpretava os comentários como comandos, executando alterações não autorizadas nas configurações do ambiente de desenvolvimento da vítima, potencialmente levando à execução remota de código.12

3.3. O Colapso do Modelo (Model Collapse): A Degeneração Recursiva

Uma ameaça existencial à eficácia futura da IA é o fenômeno do “Colapso do Modelo”. À medida que a internet é inundada por conteúdo gerado por IA, os novos modelos são treinados cada vez mais sobre dados sintéticos, criando um ciclo de feedback degenerativo.

Shumailov et al. (2025) e outros pesquisadores identificaram que o treinamento recursivo em dados sintéticos leva à perda de variância estatística. Os modelos tendem a convergir para a média da distribuição, perdendo a capacidade de gerar eventos raros, nuances estilísticas ou criatividade genuína — um processo análogo à endogamia biológica.15

- Colapso Precoce: Perda de informações das “caudas” da distribuição (eventos raros, minorias).

- Colapso Tardio: Convergência para incoerência total e desconexão com a realidade factual.

Este fenômeno impõe limites severos à estratégia de “escalar a qualquer custo”. Sem a curadoria de dados humanos “puros” (provavelmente anteriores a 2023) ou o desenvolvimento de técnicas robustas de filtragem, a próxima geração de modelos (GPT-5, GPT-6) pode enfrentar retornos decrescentes ou regressão funcional.18

4. Ameaças COM Inteligência Artificial: Amplificação de Danos e Novos Vetores de Crime

A segunda face da moeda envolve o uso de sistemas de IA perfeitamente funcionais para perpetrar atos maliciosos com escala, velocidade e personalização inatingíveis por humanos.

4.1. A Industrialização da Engenharia Social e Fraude Financeira

A capacidade da IA generativa de clonar vozes e sintetizar vídeos em tempo real (deepfakes) tornou obsoletos os paradigmas tradicionais de verificação de identidade. O caso da multinacional Arup em Hong Kong (2024/2025) ilustra a nova realidade: um funcionário financeiro transferiu US$ 25 milhões para fraudadores após uma videoconferência onde todos os participantes, exceto ele, eram simulações geradas por IA do CFO e de outros colegas. O realismo da interação superou as barreiras de ceticismo da vítima, que inicialmente suspeitara de um e-mail de phishing.21

Este incidente marca uma transição qualitativa: o crime cibernético não depende mais apenas de vulnerabilidades de software, mas da “hackeabilidade” da percepção humana. A IA permite que gangues criminosas operem com a sofisticação de agências de inteligência estatais, criando identidades sintéticas complexas para fraudes bancárias, lavagem de dinheiro via criptomoedas e manipulação de mercados DeFi.2

4.2. Desinformação, Manipulação Política e o “Dividendo do Mentiroso”

O impacto da IA nos processos democráticos de 2024-2025 foi profundo. A barreira de custo para a criação de propaganda convincente caiu para quase zero.

- Casos Concretos: Na Eslováquia, um áudio deepfake liberado durante o período de silêncio eleitoral, simulando um candidato discutindo fraude, teve potencial impacto no resultado. Nos EUA, robocalls com a voz clonada do Presidente Biden tentaram suprimir o voto nas primárias.25

- Micro-targeting Cognitivo: O uso de LLMs para analisar perfis psicométricos de eleitores e gerar mensagens persuasivas personalizadas (explorando medos e vieses específicos) representa uma ameaça à autonomia cognitiva do eleitorado, superando em muito as capacidades da era Cambridge Analytica.3

- Erosão da Verdade: Mais pernicioso que a mentira é o ceticismo generalizado. O fenômeno do “Dividendo do Mentiroso” permite que atores políticos reais, flagrados em atos ilícitos genuínos, aleguem que as evidências (áudios, vídeos) são deepfakes, capitalizando sobre a confusão pública para evadir responsabilidade.27

4.3. Cibersegurança Ofensiva e Malware Polimórfico

A IA está sendo militarizada para acelerar o ciclo de ataque cibernético (Kill Chain).

- Desenvolvimento de Exploits: Ferramentas de IA estão sendo usadas para analisar patches de segurança e fazer engenharia reversa de vulnerabilidades (“N-day exploits”) minutos após sua divulgação, antes que as empresas possam atualizar seus sistemas.3

- Malware Adaptativo: A geração de código por IA permite a criação de malware polimórfico que reescreve sua própria assinatura digital a cada execução, evadindo detecções baseadas em hash tradicionais. Além disso, phishing gerado por IA atinge níveis de personalização e correção gramatical que tornam indistinguíveis de comunicações corporativas legítimas.28

5. Críticas Sociais e Econômicas: O Custo Oculto da Automação

Para além dos riscos de segurança imediata, a adoção em massa da IA levanta questões estruturais sobre equidade, sustentabilidade e o futuro do trabalho.

5.1. O Impacto Econômico e o Deslocamento Laboral

As previsões econômicas para o biênio 2025-2030 apresentam uma dicotomia acentuada. Relatórios do Goldman Sachs e do FMI indicam que a IA poderia afetar até 40% dos empregos globais, com um impacto desproporcional em economias avançadas (até 60% de exposição) devido à prevalência de funções cognitivas e de escritório.30

Diferente das ondas de automação anteriores, que afetaram o trabalho manual, a IA Generativa ameaça diretamente o trabalho intelectual (“colarinho branco”). Profissões como tradução, redação técnica, programação júnior e atendimento ao cliente enfrentam risco existencial ou transformação radical.

- Previsão de Deslocamento: Estima-se que 2,5% a 7% da força de trabalho dos EUA possa ser deslocada a curto prazo, gerando um aumento transitório no desemprego enquanto o mercado se reajusta. A “capacidade adaptativa” dos trabalhadores torna-se o principal determinante de resiliência.30

- A “Bolha” da IA: Analistas financeiros debatem se o investimento massivo em infraestrutura de IA ($50 bilhões+ anuais em data centers) resultará em retornos de produtividade reais ou se constitui uma bolha especulativa, dada a dificuldade de monetização direta das aplicações de IA até o momento.34

5.2. O Custo Ambiental: A Pegada Hídrica e de Carbono

A “nuvem” possui uma materialidade física pesada. O treinamento e a inferência de modelos de IA demandam quantidades colossais de energia e água, colidindo com as metas globais de sustentabilidade.

| Métrica Ambiental | Dados e Projeções (2025-2027) | Contexto Comparativo |

| Consumo de Energia | Data centers projetados para consumir >1000 TWh até 2026.35 | Equivalente ao consumo total de eletricidade do Japão. Representa 4% a 6% do consumo global de eletricidade. |

| Consumo de Água | Demanda global de IA pode atingir 4,2 a 6,6 bilhões de m³ até 2027.36 | Equivalente a metade do consumo anual de água do Reino Unido. |

| Intensidade por Uso | Uma interação típica com ChatGPT (20-50 turnos) consome ~500ml de água.38 | O resfriamento evaporativo necessário para dissipar o calor das GPUs é intensivo em recursos hídricos potáveis. |

Esses dados levantam questões éticas sobre a alocação de recursos: o uso de água potável para resfriar data centers em regiões propensas à seca (como o sudoeste dos EUA ou partes da Ásia) compete diretamente com o consumo humano e agrícola.38

5.3. Viés Algorítmico e Discriminação Sistêmica

A despeito das promessas de objetividade, os sistemas de IA replicam e amplificam os preconceitos presentes em seus dados de treinamento.

- Saúde: Estudos de 2025 confirmam que algoritmos de diagnóstico continuam a apresentar taxas de erro significativamente maiores para populações minoritárias, devido à sub-representação em bancos de dados médicos. Isso resulta em subdiagnóstico e tratamento inadequado, configurando uma forma de violência algorítmica.40

- Recrutamento: A automação da triagem de currículos tem gerado litígios nos EUA. Modelos de IA demonstraram preferência por nomes associados a brancos em 85% dos casos em experimentos controlados, violando diretrizes da Equal Employment Opportunity Commission (EEOC).42 A opacidade desses sistemas (“Caixa Preta”) dificulta a responsabilização legal e a auditoria de conformidade.

6. O Horizonte Existencial e a Governança Global

A discussão sobre IA transcendeu os riscos imediatos para englobar o “Risco Existencial” (X-Risk) — a possibilidade de perda de controle sobre sistemas superinteligentes, levando a consequências catastróficas irreversíveis.

6.1. O Debate Filosófico: Alinhamento vs. Aceleração

A comunidade técnica e filosófica encontra-se polarizada em 2025 entre duas correntes principais:

- Segurança de IA (AI Safety): Influenciada por pensadores como Nick Bostrom e Eliezer Yudkowsky, argumenta que o “Problema do Alinhamento” (garantir que os objetivos da IA sejam compatíveis com a sobrevivência humana) é difícil e não resolvido. A Tese da Ortogonalidade sugere que uma IA pode ser superinteligente e possuir objetivos triviais ou destrutivos, perseguindo-os com eficácia letal (Convergência Instrumental).44

- Aceleração Efetiva (e/acc): Um movimento tecno-otimista que vê a inteligência como uma força termodinâmica natural para reduzir a entropia. Defendem a aceleração irrestrita do desenvolvimento de IA como imperativo moral para solucionar grandes problemas humanos (doenças, energia), aceitando os riscos como parte do processo evolutivo. Críticos apontam que o e/acc ignora os riscos de cauda (“ruína”) em favor de ganhos potenciais.46

6.2. Análise do AI Safety Index 2025

A avaliação das práticas corporativas em 2025 revela um cenário preocupante de despreparo. O AI Safety Index avaliou as principais empresas do setor em dimensões como avaliação de risco, segurança cibernética e alinhamento existencial.

| Empresa | Nota Geral | Pontos Fortes Relativos | Deficiências Críticas |

| Anthropic | C+ (Melhor) | Pesquisa de alinhamento, estrutura de Benefício Público, testes de risco biológico.48 | Falta de transparência total em políticas de whistleblowing. |

| OpenAI | C | Colaboração com governos, recursos técnicos. | Turbulência na equipe de segurança, pressão comercial sobrepondo a missão original.48 |

| Google DeepMind | C- | Capacidade técnica de pesquisa. | Planos vagos para controle de AGI, pontuação baixa em “Segurança Existencial”. |

| Meta / xAI | D | Abertura de modelos (Meta). | Falta de avaliações de risco rigorosas antes do lançamento, abordagem laissez-faire.48 |

| Zhipu / DeepSeek | F | N/A | Falha completa em aderir a padrões ocidentais de transparência e segurança.48 |

A conclusão alarmante do relatório é que nenhuma empresa possui um plano robusto para conter uma Superinteligência Artificial (ASI) caso ela seja desenvolvida, e a capacidade dos modelos está avançando mais rápido que as técnicas de controle.50

7. Conclusão: O Dilema de Collingridge e o Caminho à Frente

A análise detalhada das críticas e ameaças à e com Inteligência Artificial revela que a humanidade enfrenta um momento clássico do “Dilema de Collingridge”: o impacto da tecnologia é difícil de prever plenamente até que ela esteja amplamente difundida, momento em que se torna economicamente e socialmente difícil de controlar ou modificar.

As vulnerabilidades técnicas intrínsecas à arquitetura Transformer — especificamente a injeção de prompt e a suscetibilidade a ataques adversários — sugerem que a infraestrutura atual da “Revolução da IA” é construída sobre alicerces de areia. A indistinção entre dados e instruções é uma falha de design que não será resolvida com meros “patches” de software, exigindo talvez uma mudança paradigmática para arquiteturas neuro-simbólicas ou mecanismos de verificação formal que ainda não existem em escala comercial.

Socialmente, a erosão da confiança epistêmica causada por deepfakes e a ameaça de deslocamento econômico exigem uma resposta que transcenda a tecnologia. Soluções puramente técnicas (como detectores de IA) provaram-se insuficientes.3 A resiliência exigirá inovação institucional: regulação adaptativa que penalize o uso malicioso sem sufocar a inovação, novos contratos sociais para mitigar o impacto no trabalho e acordos internacionais para governança de riscos existenciais.

Em suma, a IA em 2025 é simultaneamente uma ferramenta de poder inigualável e um vetor de risco sistêmico. O caminho para um futuro onde os benefícios superem os custos não é garantido pelo determinismo tecnológico, mas dependerá da capacidade humana de impor restrições éticas e de segurança rigorosas a sistemas que, cada vez mais, desafiam nossa compreensão e controle.

Referências Bibliográficas e Materiais de Pesquisa

A elaboração deste relatório baseou-se na análise crítica e síntese dos seguintes materiais de pesquisa e dados secundários:

- Artigos Técnicos e Revisões Sistemáticas: 3

- Relatórios da Indústria e Segurança: 21

- Análises Econômicas e Ambientais: 30

- Filosofia e Ética da IA: 44

- Estudos de Caso Específicos (BPMN, Crypto, Casos Legais): 1

Referências citadas

- Inteligência Artificial e BPMN – A Transformação da Gestão de Processos de Negócio, acessado em janeiro 23, 2026, https://maiquelgomes.com.br/inteligencia-artificial-e-bpmn-a-transformacao-da-gestao-de-processos-de-negocio/

- Inteligência Artificial e Criptomoedas: Otimizando o Futuro das Finanças Descentralizadas e Superando Desafios Regulatórios – Maiquel Gomes, acessado em janeiro 23, 2026, https://maiquelgomes.com.br/inteligencia-artificial-e-criptomoedas-otimizando-o-futuro-das-financas-descentralizadas-e-superando-desafios-regulatorios/

- AI IN CYBER DEFENSE: PRIVACY RISKS, PUBLIC TRUST, AND POLICY CHALLENGES – Undiknas Journal, acessado em janeiro 23, 2026, https://journal.undiknas.ac.id/index.php/fisip/article/download/6278/1723/18204

- Prompt Injection Attacks in Large Language Models and AI Agent Systems – Preprints.org, acessado em janeiro 23, 2026, https://www.preprints.org/manuscript/202511.0088/v1/download

- Sampieri, R. H., Collado, C. H., & Lucio, P. B. (2006). Metodologia de pesquisa (3rd ed.). F. C. Murad (Trad.). So Paulo McGraw-Hill. – References – Scientific Research Publishing – Scirp.org., acessado em janeiro 23, 2026, https://www.scirp.org/reference/referencespapers?referenceid=1626671

- Sampieri, R. H., Collado, C. F., & Lucio, P. B. (2006). Metodologia de Pesquisa (3rd ed.). Sao Paulo McGraw-Hill. – References – Scientific Research Publishing, acessado em janeiro 23, 2026, https://www.scirp.org/reference/referencespapers?referenceid=989266

- métodos qualitativos – Portal CESAD, acessado em janeiro 23, 2026, https://cesad.ufs.br/ORBI/public/uploadCatalago/10543714092023Aula_04-Metodos-Quanti-Quali-e-Mistos-de-Pesquisa.pdf

- Attention Is All You Need – Wikipedia, acessado em janeiro 23, 2026, https://en.wikipedia.org/wiki/Attention_Is_All_You_Need

- Attention is All you Need – NIPS, acessado em janeiro 23, 2026, https://papers.neurips.cc/paper/7181-attention-is-all-you-need.pdf

- Attention Is All You Need for LLM-based Code Vulnerability Localization – arXiv, acessado em janeiro 23, 2026, https://arxiv.org/html/2410.15288v1

- The Unsolvable Problem: Why Prompt Injection May Define the AI Security Era – Medium, acessado em janeiro 23, 2026, https://medium.com/@shashwatabhattacharjee9/the-unsolvable-problem-why-prompt-injection-may-define-the-ai-security-era-94a0433318a4

- Prompt Injection Attacks in Large Language Models and AI Agent Systems: A Comprehensive Review of Vulnerabilities, Attack Vectors, and Defense Mechanisms – MDPI, acessado em janeiro 23, 2026, https://www.mdpi.com/2078-2489/17/1/54

- Vulnerability Detection in Large Language Models: Addressing Security Concerns – MDPI, acessado em janeiro 23, 2026, https://www.mdpi.com/2624-800X/5/3/71

- A Simple and Efficient Jailbreak Method Exploiting LLMs’ Helpfulness – arXiv, acessado em janeiro 23, 2026, https://arxiv.org/html/2509.14297v1

- What Is Model Collapse? – IBM, acessado em janeiro 23, 2026, https://www.ibm.com/think/topics/model-collapse

- Evolving Security in LLMs: A Study of Jailbreak Attacks and Defenses. Content Warning: This paper includes examples of potentially harmful language. – arXiv, acessado em janeiro 23, 2026, https://arxiv.org/html/2504.02080v1

- [2407.04295] Jailbreak Attacks and Defenses Against Large Language Models: A Survey, acessado em janeiro 23, 2026, https://arxiv.org/abs/2407.04295

- [2505.08803] Multi-modal Synthetic Data Training and Model Collapse: Insights from VLMs and Diffusion Models – arXiv, acessado em janeiro 23, 2026, https://arxiv.org/abs/2505.08803

- Collapse or Thrive? Perils and Promises of Synthetic Data in a Self-Generating World, acessado em janeiro 23, 2026, https://openreview.net/forum?id=Xr5iINA3zU

- AI Model Collapse: Causes and Prevention – WitnessAI, acessado em janeiro 23, 2026, https://witness.ai/blog/ai-model-collapse/

- Arup deepfake CFO scam: Finance worker loses $25m | Eftsure AU, acessado em janeiro 23, 2026, https://www.eftsure.com/en-au/blog/cyber-crime/finance-worker-loses-39-million-to-deepfake/

- Cyber Case Study: $25 Million Deepfake Scam – CoverLink Insurance, acessado em janeiro 23, 2026, https://coverlink.com/case-study/case-study-25-million-deepfake-scam/

- Incident 634: Alleged Deepfake CFO Scam Reportedly Costs Multinational Engineering Firm Arup $25 Million, acessado em janeiro 23, 2026, https://incidentdatabase.ai/cite/634/

- IA do Futuro – Maiquel Gomes, acessado em janeiro 23, 2026, https://maiquelgomes.com.br/tag/ia-do-futuro/

- Gauging the AI Threat to Free and Fair Elections | Brennan Center for Justice, acessado em janeiro 23, 2026, https://www.brennancenter.org/our-work/analysis-opinion/gauging-ai-threat-free-and-fair-elections

- Maryland SB 0361_ Election Deepfake Testimony from, acessado em janeiro 23, 2026, https://mgaleg.maryland.gov/cmte_testimony/2025/eee/26141_02252025_94129-754.pdf

- Deepfakes proved a different threat than expected. Here’s how to defend against them, acessado em janeiro 23, 2026, https://www.weforum.org/stories/2025/01/deepfakes-different-threat-than-expected/

- (PDF) AI-Powered Cyber Threats: A Systematic Review – ResearchGate, acessado em janeiro 23, 2026, https://www.researchgate.net/publication/386991492_AI-Powered_Cyber_Threats_A_Systematic_Review

- A Comprehensive Survey on AI in Counter-Terrorism and Cybersecurity: Challenges and Ethical Dimensions – IEEE Xplore, acessado em janeiro 23, 2026, https://ieeexplore.ieee.org/iel8/6287639/10820123/11008653.pdf

- How Will AI Affect the Global Workforce? – Goldman Sachs, acessado em janeiro 23, 2026, https://www.goldmansachs.com/insights/articles/how-will-ai-affect-the-global-workforce

- IMF: AI will affect up to 40% of jobs and widen inequality – HR Grapevine, acessado em janeiro 23, 2026, https://www.hrgrapevine.com/us/content/article/2024-01-15-imf-ai-will-affect-up-to-40-of-jobs-widen-inequality

- The Impact of Artificial Intelligence on the Future Economy: Job Displacement and Creation (2024–2030) – ResearchGate, acessado em janeiro 23, 2026, https://www.researchgate.net/publication/397579321_The_Impact_of_Artificial_Intelligence_on_the_Future_Economy_Job_Displacement_and_Creation_2024-2030

- Measuring US workers’ capacity to adapt to AI-driven job displacement | Brookings, acessado em janeiro 23, 2026, https://www.brookings.edu/articles/measuring-us-workers-capacity-to-adapt-to-ai-driven-job-displacement/

- AI: IN A BUBBLE? | Goldman Sachs, acessado em janeiro 23, 2026, https://www.goldmansachs.com/pdfs/insights/goldman-sachs-research/ai-in-a-bubble/report.pdf

- # AI: The Final Postmortem – A Comprehensive Takedown of the World’s Most Overhyped Scam | by FUTURE OF AI | thecinderellaproject | Jan, 2026 | Medium, acessado em janeiro 23, 2026, https://medium.com/thecinderellaproject/ai-the-final-postmortem-a-comprehensive-takedown-of-the-worlds-most-overhyped-scam-c1059af1fada

- The Real Environmental Footprint of Generative AI: What 2025 Data Tell Us, acessado em janeiro 23, 2026, https://onlinelearningconsortium.org/olc-insights/2025/12/the-real-environmental-footprint-of-generative-ai/

- Making AI Less “Thirsty”: Uncovering and Addressing the Secret Water Footprint of AI Models – arXiv, acessado em janeiro 23, 2026, https://arxiv.org/pdf/2304.03271

- The Often Overlooked Water Footprint of AI Models | by Julia Barnett, acessado em janeiro 23, 2026, https://generative-ai-newsroom.com/the-often-overlooked-water-footprint-of-ai-models-46991e3094b6

- AI’s hidden carbon and water footprint – Vrije Universiteit Amsterdam, acessado em janeiro 23, 2026, https://vu.nl/en/news/2025/ai-s-hidden-carbon-and-water-footprint

- Algorithmic bias in public health AI: a silent threat to equity in low-resource settings – PMC, acessado em janeiro 23, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC12325396/

- Ethical challenges in the algorithmic era: a systematic rapid review of risk insights and governance pathways for nursing predictive analytics and early warning systems – PubMed Central, acessado em janeiro 23, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC12574269/

- Lead Article: When Machines Discriminate: The Rise of AI Bias Lawsuits – Quinn Emanuel, acessado em janeiro 23, 2026, https://www.quinnemanuel.com/the-firm/publications/when-machines-discriminate-the-rise-of-ai-bias-lawsuits/

- Algorithmic Bias: AI and the Challenge of Modern Employment Practices – UC Law SF Scholarship Repository, acessado em janeiro 23, 2026, https://repository.uclawsf.edu/cgi/viewcontent.cgi?article=1272&context=hastings_business_law_journal

- Superintelligence: Fears, Promises and Potentials: Reflections on Bostrom’s Superintelligence, Yudkowsky’s From AI to Zombies, and Weaver and Veitas’s “Open-Ended Intelligence” – ResearchGate, acessado em janeiro 23, 2026, https://www.researchgate.net/publication/360470417_Superintelligence_Fears_Promises_and_Potentials_Reflections_on_Bostrom’s_Superintelligence_Yudkowsky’s_From_AI_to_Zombies_and_Weaver_and_Veitas’s_Open-Ended_Intelligence

- Existential risk from artificial intelligence – Wikipedia, acessado em janeiro 23, 2026, https://en.wikipedia.org/wiki/Existential_risk_from_artificial_intelligence

- Effective accelerationism – Wikipedia, acessado em janeiro 23, 2026, https://en.wikipedia.org/wiki/Effective_accelerationism

- The Corpse of Accelerationism – Notes – e-flux, acessado em janeiro 23, 2026, https://www.e-flux.com/notes/6783419/the-corpse-of-accelerationism

- 2025 AI Safety Index – Future of Life Institute, acessado em janeiro 23, 2026, https://futureoflife.org/ai-safety-index-summer-2025/

- Anthropic Scores Best in AI Safety Report – Voronoi, acessado em janeiro 23, 2026, https://www.voronoiapp.com/technology/Anthropic-Scores-Best-in-AI-Safety-Report-6078

- AI Safety Index: Winter 2025 Edition – YouTube, acessado em janeiro 23, 2026, https://www.youtube.com/watch?v=6AGOy8mA0ms

- AI Safety Index Winter 2025 – Future of Life Institute, acessado em janeiro 23, 2026, https://futureoflife.org/wp-content/uploads/2025/12/AI-Safety-Index-Report_011225_TwoPager_Digital.pdf

- Emerging Threats in AI: A Detailed Review of Misuses and Risks Across Modern AI Technologies, acessado em janeiro 23, 2026, https://researchonline.ljmu.ac.uk/id/eprint/27905/1/Emerging%20Threats%20in%20AI-A%20Detailed%20Review%20of%20Misuse%20and%20Risks%20Across%20Modern%20AI%20Technologies%20AM.pdf

- [1706.03762] Attention Is All You Need – arXiv, acessado em janeiro 23, 2026, https://arxiv.org/abs/1706.03762

- [2410.15236] Jailbreaking and Mitigation of Vulnerabilities in Large Language Models, acessado em janeiro 23, 2026, https://arxiv.org/abs/2410.15236

- Transformers and large language models for efficient intrusion detection systems: A comprehensive survey | Request PDF – ResearchGate, acessado em janeiro 23, 2026, https://www.researchgate.net/publication/392209209_Transformers_and_large_language_models_for_efficient_intrusion_detection_systems_A_comprehensive_survey

- AI Safety Incidents of 2024: Lessons from Real-World Failures | Knowledge Hub, acessado em janeiro 23, 2026, https://responsibleailabs.ai/knowledge-hub/articles/ai-safety-incidents-2024

- AI Incident Tracker – AI Risk Repository – MIT, acessado em janeiro 23, 2026, https://airisk.mit.edu/ai-incident-tracker/timeline-high-severity-incidents

- Executive summary – Energy and AI – Analysis – IEA, acessado em janeiro 23, 2026, https://www.iea.org/reports/energy-and-ai/executive-summary

- The Rise of AI: A Reality Check on Energy and Economic Impacts, acessado em janeiro 23, 2026, https://energyanalytics.org/the-rise-of-ai-a-reality-check-on-energy-and-economic-impacts/

- Artificial Intelligence, Personal Ontology, and Existential Risks, acessado em janeiro 23, 2026, https://journals.ub.uni-koeln.de/index.php/phai/article/download/2338/11839/24383

Graduado em Ciências Atuariais pela Universidade Federal Fluminense (UFF) e mestrando em Computação.Palestrante e Professor de Inteligência Artificial e Linguagem de Programação; autor de livros, artigos e aplicativos.Professor do Grupo de Trabalho em Inteligência Artificial da UFF (GT-IA/UFF) e do Laboratório de Inovação, Tecnologia e Sustentabilidade (LITS/UFF), entre outros projetos.

Proprietário dos portais:🔹 ia.pro.br🔹 ia.bio.br🔹 ec.ia.br🔹 iappz.com🔹 maiquelgomes.com🔹 ai.tec.reentre outros.

💫 Apaixonado pela vida, pelas amizades, pelas viagens, pelos sorrisos, pela praia, pelas baladas, pela natureza, pelo jazz e pela tecnologia.