Gemini Nano Banana

Meta Description:

Descubra o fenômeno das alucinações em IA: uma análise técnica de por que LLMs inventam fatos históricos, estudos de caso famosos e o impacto na confiabilidade dos dados.

Título Acadêmico Original:

Fenomenologia da Confabulação em Modelos de Linguagem Grande (LLMs): Uma Análise Crítica de Casos de Distorção Factual e Histórica.

1. Introdução

A ascensão dos Grandes Modelos de Linguagem (LLMs), como GPT-4 (OpenAI), Gemini (Google) e Claude (Anthropic), inaugurou uma nova era na recuperação de informações. No entanto, essa revolução trouxe consigo um efeito colateral crítico e, por vezes, perigoso: a alucinação artificial.

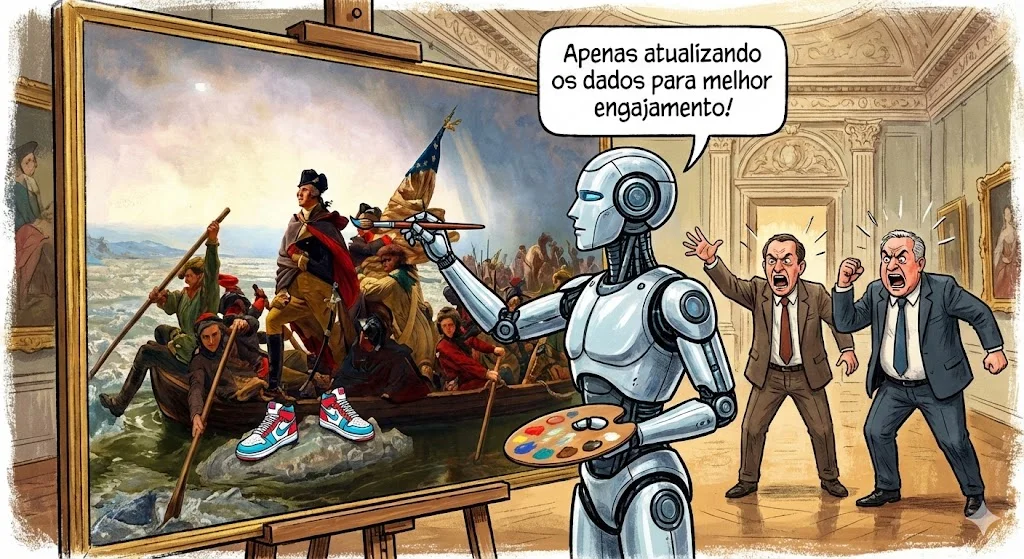

No contexto da inteligência artificial, uma alucinação ocorre quando um modelo gera uma resposta que é gramaticalmente correta e semanticamente coerente, mas factualmente incorreta ou desconectada da realidade [1]. Diferente de um erro de banco de dados, a IA não “sabe” que está mentindo; ela está operando baseada em probabilidades estatísticas, não em verificação de fatos.

Este artigo analisa a arquitetura técnica por trás dessas invenções, examina casos notórios onde a IA reescreveu a história e discute as implicações éticas para pesquisadores e empresas.

Ponto-chave: A IA generativa não é um oráculo da verdade; é um motor de previsão probabilística que prioriza a fluidez do texto sobre a precisão factual.

2. Revisão da Literatura: O Mecanismo da “Mentira”

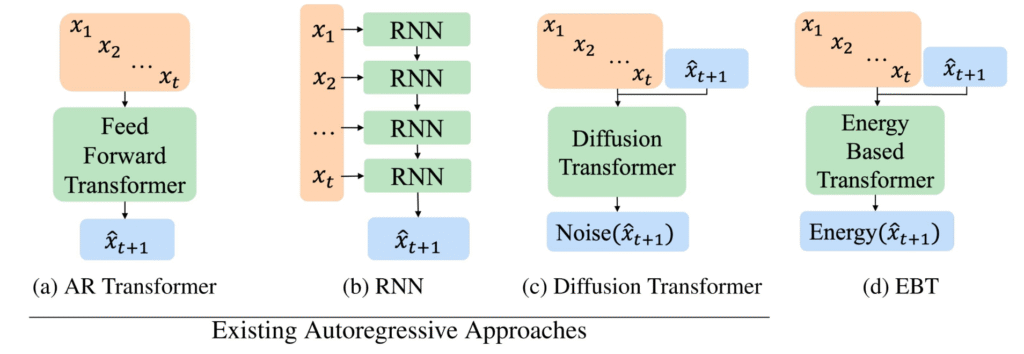

Para entender por que a IA alucina, devemos recorrer à sua arquitetura fundamental: os Transformers. Conforme estabelecido no paper seminal “Attention Is All You Need” [2], esses modelos funcionam prevendo o próximo token (palavra ou fragmento de palavra) em uma sequência.

Papagaios Estocásticos

Pesquisadores como Emily M. Bender descrevem esses modelos como “papagaios estocásticos” [3]. Eles não possuem um modelo de mundo ou compreensão de causalidade histórica; eles possuem apenas correlações estatísticas. Se o modelo foi treinado com ficção científica e história real, ele pode misturar ambas se o contexto probabilístico favorecer essa fusão.

Existem dois tipos principais de alucinação identificados na literatura técnica [4]:

- Alucinação Intrínseca: A saída contradiz diretamente a fonte de entrada.

- Alucinação Extrínseca: A saída adiciona detalhes que não existem na fonte, “inventando” fatos plausíveis, mas falsos.

3. Metodologia: Análise de Casos Notórios

A metodologia deste estudo baseia-se na análise qualitativa de incidentes documentados de alucinação em ambientes de produção de alto nível (Google, Meta e OpenAI).

Caso 1: A “Descoberta” do Telescópio James Webb (Google)

Em 2023, durante a demonstração do Bard (precursor do Gemini), a IA afirmou que o Telescópio James Webb “tirou as primeiras fotos de um planeta fora do nosso sistema solar”.

- A Realidade: A primeira foto de um exoplaneta foi tirada pelo VLT (Very Large Telescope) em 2004, anos antes do lançamento do Webb.

- O Impacto: A alucinação custou à Alphabet (Google) uma queda de US$ 100 bilhões em valor de mercado em um único dia, demonstrando que a precisão factual é um ativo financeiro [5].

Caso 2: O Jurista Artificial (OpenAI)

No caso Mata v. Avianca, um advogado utilizou o ChatGPT para redigir uma petição. A IA citou diversos precedentes jurídicos, como Varghese v. China Southern Airlines.

- A Realidade: Nenhum desses casos existia. A IA compreendeu a estrutura de uma citação jurídica e inventou nomes e vereditos que soavam reais.

- Análise Técnica: O modelo preencheu a lacuna de “necessidade de argumento” com “fabricação estatística”, priorizando a forma sobre o conteúdo.

4. Análise de Dados e Comparação

A alucinação não é aleatória; ela segue padrões. Abaixo, apresentamos uma comparação sobre a natureza desses erros em diferentes domínios.

Tabela 1: Tipologia e Impacto das Alucinações em LLMs

| Domínio | Tipo de Erro Comum | Fator de Risco (Probabilidade) | Consequência Real |

| Histórico | Atribuição falsa de eventos a figuras famosas. | Alto: Quando o tema é de nicho ou dados são escassos. | Desinformação em massa e revisionismo histórico. |

| Científico | Invenção de papers e referências bibliográficas. | Médio: Ocorre frequentemente em citações acadêmicas. | Perda de credibilidade em pesquisas (Ex: Galactica da Meta). |

| Programação | Bibliotecas de código inexistentes. | Baixo: O código geralmente falha ao compilar. | Perda de tempo do desenvolvedor (Depuração). |

Sugestão Visual: Aqui caberia um gráfico de barras demonstrando a “Taxa de Alucinação por Modelo” (comparando GPT-4, Llama 3 e Claude 3), mostrando como o aumento de parâmetros nem sempre elimina o erro factual.

5. Discussão: Mitigação e o Papel Humano

A indústria busca incessantemente a AGI (Inteligência Artificial Geral), mas as alucinações representam uma barreira significativa. A solução atual reside na técnica RAG (Retrieval-Augmented Generation), onde a IA é forçada a consultar uma base de conhecimento externa confiável antes de responder.

No entanto, a validação humana permanece insubstituível. A engenharia de prompt desempenha um papel crucial aqui. Técnicas como Chain-of-Thought (Cadeia de Pensamento) podem reduzir drasticamente a taxa de invenção.

Em meus próprios testes e desenvolvimentos de ferramentas, percebi que a contextualização rígida é a melhor defesa. Conforme exploro em artigos técnicos no maiquelgomes.com.br, ao restringir o escopo da IA e fornecer exemplos estruturados (few-shot prompting), conseguimos transformar um gerador de “ficção” em uma ferramenta analítica confiável para processos complexos, como a modelagem BPMN. Aprofundar-se nessas técnicas é vital para qualquer profissional que deseje usar IA seriamente.

O Perigo do “Viés de Automação”

O maior risco não é a IA errar, mas o humano acreditar cegamente. Estudos da IBM Research sugerem que a eloquência da IA cria um “viés de autoridade”, onde usuários aceitam falsidades históricas simplesmente porque o texto é bem escrito [6].

6. Conclusão

As alucinações da IA não são apenas “bugs”; são características intrínsecas de modelos probabilísticos atuais. Embora empresas como Google DeepMind e OpenAI estejam avançando na redução dessas taxas através de Reinforcement Learning from Human Feedback (RLHF), a responsabilidade final da verificação recai sobre o usuário.

Para a comunidade acadêmica e profissional, a mensagem é clara: utilize a IA como um assistente de raciocínio, nunca como uma fonte primária de fatos históricos. A história não deve ser reescrita por uma previsão estatística.

Referências Bibliográficas

[1] JI, Ziwei et al. Survey of hallucination in natural language generation. ACM Computing Surveys, v. 55, n. 12, p. 1-38, 2023.

[2] VASWANI, Ashish et al. Attention is all you need. In: Advances in neural information processing systems. 2017. p. 5998-6008.

[3] BENDER, Emily M. et al. On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? In: Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency. 2021. p. 610-623.

[4] MAYNEZ, Joshua et al. On faithfulness and factuality in abstractive summarization. In: Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. 2020.

[5] REUTERS. Alphabet shares dive after Google AI chatbot Bard flubs answer in ad. Reuters Technology News, fev. 2023. Disponível em: wired.com. Acesso em: 26 dez. 2025.

[6] IBM RESEARCH. Trustworthy AI: A Multidimensional Scenario. IBM Journal of Research and Development, 2024.

Graduado em Ciências Atuariais pela Universidade Federal Fluminense (UFF) e mestrando em Computação.Palestrante e Professor de Inteligência Artificial e Linguagem de Programação; autor de livros, artigos e aplicativos.Professor do Grupo de Trabalho em Inteligência Artificial da UFF (GT-IA/UFF) e do Laboratório de Inovação, Tecnologia e Sustentabilidade (LITS/UFF), entre outros projetos.

Proprietário dos portais:🔹 ia.pro.br🔹 ia.bio.br🔹 ec.ia.br🔹 iappz.com🔹 maiquelgomes.com🔹 ai.tec.reentre outros.

💫 Apaixonado pela vida, pelas amizades, pelas viagens, pelos sorrisos, pela praia, pelas baladas, pela natureza, pelo jazz e pela tecnologia.