Se você achava que a inteligência artificial estava presa num loop infinito de gerar textões como se fosse um influencer desesperado por likes, segura essa: um paper novinho sobre IA, tão interessante que até o Yann LeCun, o padrinho do Deep Learning, deve ter dado um joinha interno. Ele apresenta os Energy-Based Transformers (EBTs), uma arquitetura que pode mandar os modelos atuais pra terapia de grupo, porque, sério, essa novidade é um divisor de águas.

Sistema 1, Sistema 2 e a IA que Só Pisa no Gás

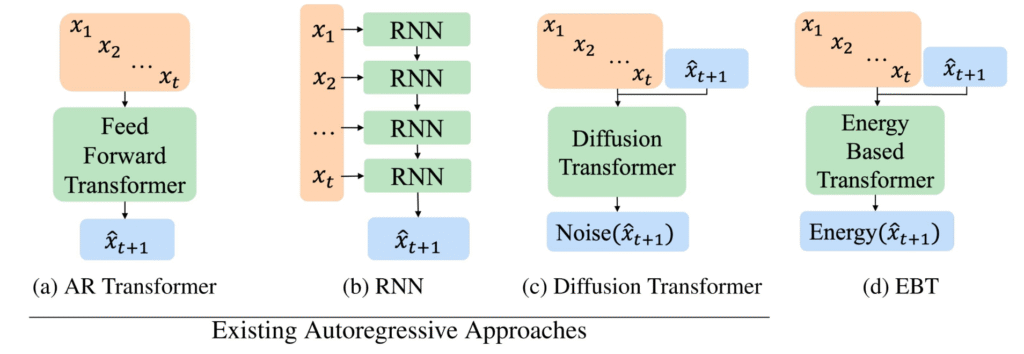

Se você já deu uma folheada no Thinking, Fast and Slow do Daniel Kahneman, sabe que nosso cérebro tem dois modos de operação: o Sistema 1, que é tipo o reflexo de desviar de uma bola voadora na sua cara, e o Sistema 2, que é o cara que senta, pensa, e tenta descobrir por que você gastou metade do salário em um fone de ouvido “premium”. As IAs de hoje, como os LLMs (Large Language Models), são feras no Sistema 1: preveem a próxima palavra, churnam textões fluidos e até enganam como se fossem PhDs. Mas quando o papo é raciocínio profundo, tipo Sistema 2? Aí elas patinam como um carro com pneu careca na chuva.

Os pesquisadores por trás dos EBTs tiveram a audácia de perguntar: “E se a gente fizesse a IA pensar devagar, como um Sistema 2, sem precisar de prompt engineering mirabolante ou supervisão humana constante?” O resultado é uma arquitetura que não só gera respostas, mas as avalia e otimiza como se fosse um filósofo robótico com um café na mão e tempo de sobra.

Como Funciona? Pense num Fiscal Interno com TOC

Diferente dos Transformers tradicionais, que são treinados pra prever o próximo token como se fossem videntes de esquina, os EBTs são tipo um crítico de cinema insuportável. Eles recebem uma pergunta e uma possível resposta e dão uma nota, chamada de “Energia”. Respostas boas têm energia baixa (pensa num cappuccino perfeito), e respostas ruins têm energia alta (tipo aquele café de máquina que parece água de poça). O processo de “pensar” é basicamente um gradient descent dessa energia: a IA começa com uma resposta meia-boca, vai polindo iterativamente, e chega na resposta ideal, como quem lapida um diamante bruto.

O pulo do gato? Isso tudo é feito de forma não-supervisionada, sem um humano corrigindo cada passo como um professor chato de redação. É a IA aprendendo a ser seu próprio revisor, e o resultado é de cair o queixo.

Resultados que Fazem o GPU Sorrir (e o Planeta Agradecer)

Os números do paper são tão impressionantes que parecem coisa de ficção científica. Comparados aos Transformers tradicionais, os EBTs foram 35% mais eficientes no pré-treinamento. Isso significa menos GPUs gritando por socorro e uma conta de luz que não parece um assalto à mão armada. Em grande escala, a economia pode ser ainda mais brutal – o tipo de coisa que faz o setor de tecnologia e o meio ambiente darem as mãos e cantarem Kumbaya.

E tem mais: quanto mais “tempo” (ou passos de otimização) os EBTs têm pra pensar, melhor eles se saem. Em tarefas de linguagem, os ganhos chegaram a 29%, e em tarefas de imagem, como denoising, eles precisaram de até 99% menos passos. Isso mesmo: enquanto os Transformers padrão estão lá, suando pra resolver problemas, os EBTs cruzam a linha de chegada tomando um suco.

A IA que Sabe Quando Não Sabe

Um dos pontos mais legais é que os EBTs desenvolveram, de forma emergente, uma noção de incerteza. Pra problemas simples, eles acham uma resposta de baixa energia rapidinho, como quem resolve uma conta de padaria. Mas em problemas complexos, a energia fica alta por mais tempo, como se a IA dissesse: “Peraí, tá osso, deixa eu pensar direito”. Isso é ouro puro, porque significa que o modelo “sabe quando não sabe” e continua buscando a melhor resposta.

E não para por aí: os EBTs são mestres em generalização. Eles se saem melhor em tarefas novas, especialmente em dados bem diferentes dos usados no treino (out-of-distribution), que é onde os modelos tradicionais costumam engasgar. O ganho de “pensar mais” é ainda maior nesses cenários, o que sugere que os EBTs podem ser a chave pra um raciocínio mais robusto e confiável.

O Futuro: Menos “Gerar”, Mais “Verificar”

Na prática, os EBTs são uma potencial virada de jogo. Em vez de focar em modelos que só “geram” conteúdo como uma impressora 3D descontrolada, o futuro pode estar em arquiteturas que verificam e constroem respostas de forma iterativa. Isso torna o raciocínio algo nativo do modelo, não um hack aplicado por cima, como o Chain-of-Thought ou outras gambiarras que usamos hoje.

Se os EBTs entregarem o que prometem, estamos olhando pra uma nova era da IA, onde as máquinas não só falam, mas pensam – e pensam com calma, como um sábio de barba longa, mas sem a barba (e, quem sabe, com menos bugs). É o tipo de avanço que faz você querer brindar com um energy drink (trocadilho intencional) e esperar pelo próximo capítulo dessa revolução.

LINK PARA O ARTIGO

https://arxiv.org/pdf/2507.02092v1

Graduado em Ciências Atuariais pela Universidade Federal Fluminense (UFF) e mestrando em Computação.Palestrante e Professor de Inteligência Artificial e Linguagem de Programação; autor de livros, artigos e aplicativos.Professor do Grupo de Trabalho em Inteligência Artificial da UFF (GT-IA/UFF) e do Laboratório de Inovação, Tecnologia e Sustentabilidade (LITS/UFF), entre outros projetos.

Proprietário dos portais:🔹 ia.pro.br🔹 ia.bio.br🔹 ec.ia.br🔹 iappz.com🔹 maiquelgomes.com🔹 ai.tec.reentre outros.

💫 Apaixonado pela vida, pelas amizades, pelas viagens, pelos sorrisos, pela praia, pelas baladas, pela natureza, pelo jazz e pela tecnologia.